Une étude menée par des chercheurs de l’université de Bologne a démontré que deux algorithmes de prix pouvaient développer des stratégies de collusion complexes et ce, sans communiquer l’un avec l’autre et sans être conçus pour agir de cette manière. Nous reviendrons sur ce concept de « collusion algorithmique » : l’un des défis les plus importants pour les autorités de la concurrence à travers le monde.

Lorsque nous achetons en ligne, nous ne le remarquons guère mais la grande majorité des prix de biens et de services est définie par des algorithmes de prix. Déjà en 2015, plus d’un tiers des vendeurs sur Amazon fixaient leurs prix automatiquement. Aujourd’hui, la réduction du prix de ces technologies et leur facilité d’implémentation ont permis leur démocratisation à tous les vendeurs au détail sur le net.

Récemment, des chercheurs de l’université de Bologneont décidé d’étudier le comportement de ses algorithmes. Pour ce faire, ils ont développé deux intelligences artificielles basées sur l’apprentissage par renforcement. Cette méthode d’apprentissage permet à la machine d’apprendre à travers ses choix. En effet, à chaque choix, l’environnement d’apprentissage enverra des feedbacks positifs ou négatifs ce qui permettra à la machine de développer le comportement escompté par ses créateurs. En l’occurrence, les algorithmes développés devaient être capable de maximiser les profits et d’atteindre un optimum.

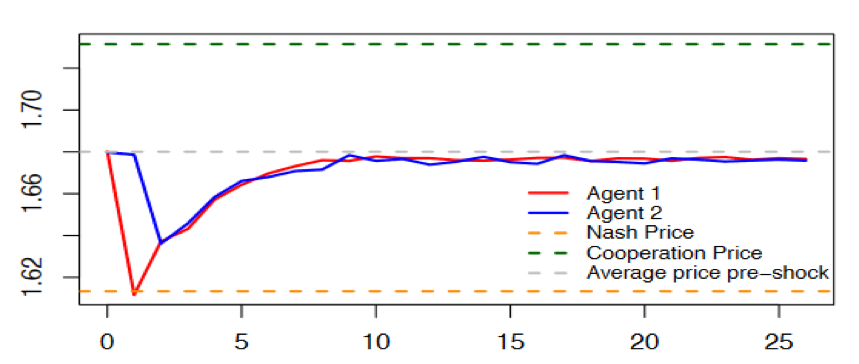

Les résultats de l’étude menée par l’Université de Bologne révèlent que ces deux IA assez simplistes, selon les propos des chercheurs, ont réussi à développer des stratégies complexes de collusion. Comme nous pouvons le voir sur le schéma ci-dessous, les chercheurs ont poussé l’algorithme rouge à s’écarter de la ligne de pointillés gris représentant le prix collusif. En réaction, l’algorithme bleu a décidé de punir l’algorithme rouge en rendant ainsi son écart peu rentable. Suite à cela, les deux algorithmes ont mécaniquement repris leur position initiale.

Source : Calvano, E., Calzolari, G., Denicolo, V., & Pastorello, S., « Artificial Intelligence, Algorithmic Pricing and Collusion », SSRN Electronic Journal, 2018, p. 29.

Les chercheurs soulignent le fait que contrairement aux humains qui sont incapables de se coordonner sans communication explicite, les algorithmes n’ont laissé aucune trace d’actions concertées. En effet, « ils apprennent à s’entendre purement par essais et erreurs, sans connaissance préalable de l’environnement dans lequel ils opèrent, sans communiquer entre eux, et sans être spécifiquement conçus ou instruits pour s’entendre. Il s’agit là d’un véritable défi pour la politique de concurrence » constatent les chercheurs.

De la fiction à la réalité

Les collusions tacites puresont toujours été vues par les économistes comme des hypothèses peu vraisemblables. D’ailleurs, Milton Friedman s’exprimait à ce sujet en ces termes : « Je ne connais aucun travail théorique qui peut dire comment un groupe de firmes peuvent se comporter de manière non-coopérative sans communiquer et choisir ou trouver le moyen d’atteindre l’équilibre Pareto-Optimal du jeu répété ». C’est pour cette raison que ce type de collusion n’est pas considéré comme illégale car, d’une part, elle ne peut se produire entre agents humains et, d’autre part, même si elle avait lieu, il serait impossible de la détecter. En effet, la quasi-impossibilité d’apporter la preuve irréfutable, la « smoking-gun evidence », rend l’application des lois antitrust dangereuses dès lors qu’elle pourrait entrainer de faux-positifs ou faux-négatifs.

Toutefois, l’avènement de l’intelligence artificielle et en particulier de l’apprentissage automatique(Machine Learning) remet en question l’existence de ses collusions tacites pures. L’ OCDEémettait déjà des craintes concernant l’utilisation d’un même algorithme par plusieurs entreprises. Programmé dans le but d’éviter la concurrence, il permettrait d’établir des prix anticoncurrentiels et ce, sans communiquer.

En revanche, la conclusion des chercheurs de Bologne décrit une situation bien plus inquiétante. Alors que dans l’hypothèse de l’OCDE, il était possible de présumer la coordination à travers des éléments tels que la sous-traitance de la création de l’algorithme à une même entreprise ; dans le cas italien, il est réellement impossible de détecter des éléments présumant l’accord étant donné que ce sont les algorithmes eux-mêmes qui apprennent à s’entendre à travers leur apprentissage par essais et erreurs.

Aucune solution, que des rustines !

Nombreuses sont les autorités de concurrence qui se sont saisis du sujet des algorithmes et de leur impact sur les marchés numériques, tel est le cas de l’autorité canadienne(2017), de l’autorité française et allemandeou de la Federal Trade Commission américaine. Ces différentes autorités avaient déjà signalé que le Big Data et l’Intelligence Artificielle couplées à une augmentation de la transparence du marché et de la capacité à comparer les prix offraient un terrain propice à la naissance de coordination de marché. En revanche, l’absence de preuve de l’existence d’accord fait entre deux ou plusieurs algorithmes rendait les débats plutôt théoriques. L’OCDE avait brillamment résumé les solutions possibles tout en y émettant des réserves :

- Plafonner les prix :Une des solutions dégagées était de plafonner les prix. Il serait possible de cette manière d’empêcher les algorithmes de dépasser un prix fixé par voie règlementaire. Néanmoins, cette idée ne résiste pas à l’analysecar ces mesures peuvent sensiblement affecter l’innovation des fournisseurs mais aussi impacter la fourniture de produits de haute qualité.

- Complexifier la mise en œuvre d’entente :Les marchés numériques sont caractérisés par leur transparence et la rapidité des réactions face aux modifications des prix. Ces éléments facilitent les ententes. Dès lors, une des solutions imaginées est de mettre en place des remises secrètes ou de limiter la publication d’information. Néanmoins ici aussi, ce genre de mesures pourraient impacter négativement le consommateur dans son choix de la bonne ou mauvaise offre. De plus, cela risque de rendre l’ajustement des prix en fonction de l’offre et de la demande plus difficile.

- Instaurer des normes au niveau de la conception des algorithmes: Une dernière solution qui a été soulevée est l’inclusion des règles du droit de la concurrence dans l’algorithme dès sa conception, une sorte de « Competition by design ». Même si l’innovation dans le secteur de la conception des algorithmes risque d’être affecté par cette mesure, elle représente la solution la moins attentatoire aux politiques de concurrence.

Parmi ces solutions, qui ne sont finalement que des pistes de réflexion, d’autres interrogations subsistent. Tel est le cas de la transparence des algorithmes et plus particulièrement ceux d’apprentissage profond. Même si le manque de transparence peut trouver sa source dans le secret d’affaire, d’autres éléments accentuent l’opacité dans le fonctionnement de ce type d’algorithmes. Ainsi, le concepteur n’est pas toujours capable de comprendre comment la machine a effectué son apprentissage ni d’expliquer les décisions prises par la machine. Ce problème de transparence pose énormément de questionsdans le domaine du droit mais aussi dans le domaine informatique et représente l’un des enjeux majeurs de cette technologie.

Finalement, même si les résultats de l’équipe italienne représentent les balbutiements en la matière, elle montre toute l’importance de se pencher sur la question des ententes tacites élaborées par des algorithmes. Même si des recherches supplémentaires doivent préciser la situation, les questions qui se posent désormais aux autorités de concurrence ne sont plus théoriques mais bel et bien pratiques. Les autorités de protection des données, les experts en apprentissage profond et les autorités de concurrence devront agir de concert afin d’élaborer des solutions efficaces pour les marchés numériques. Malheureusement, pris entre le marteau et l’enclume, des mesures médianes devront être privilégiées afin de ne pas saper l’innovation et les avantages qu’apportent les algorithmes sur ce type de marché.

Commentaires